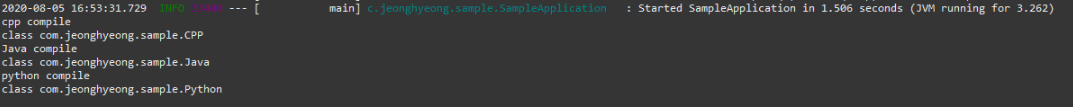

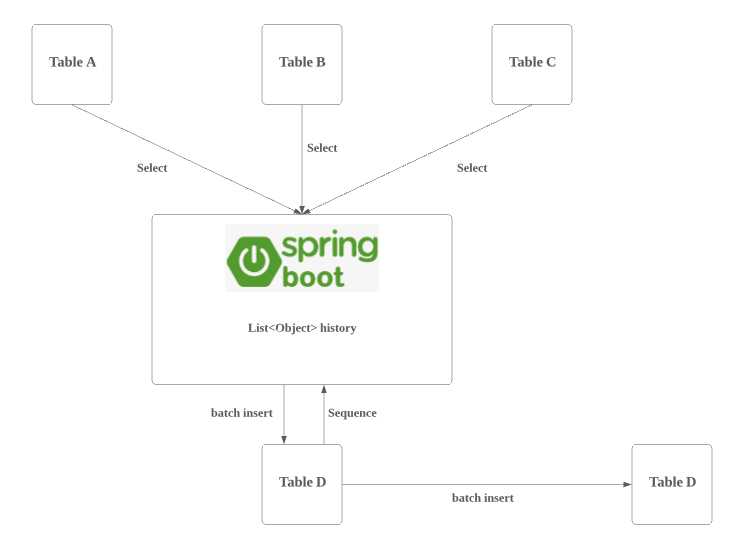

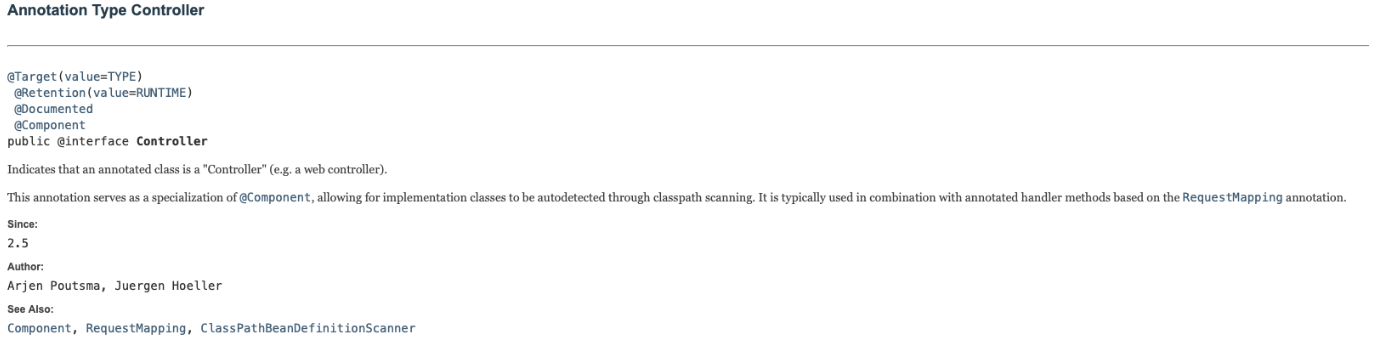

0. Table Of Content 1. 서론 2. Factory Pattern이란 무엇인가 2.1. Factory Parrern 예제 3. Factory Pattern 사용으로 얻을 수 있는 기대 효과 4. 실무에서 적용한 코드 일부 5. 후기 1. 서론 배치 프로세스에 대한 공통 프레임워크를 담당하여 작업을 진행하고 있었다. Spring Batch Starter를 사용하여 작업을 진행하는 것이 가장 효율적이었지만, 기존 만들어진 테이블에 맞춰야 했기 때문에 해당 테이블에 맞게 배치 프레임워크를 새로 개발하게 되었다. 프레임워크에서 build된 결과물인 jar파일은 crontab에 등록이 되어 jar 실행 시 입력받은 augument값으로 해당 batch job이 실행되어야 하기 때문에, 입력 argu..