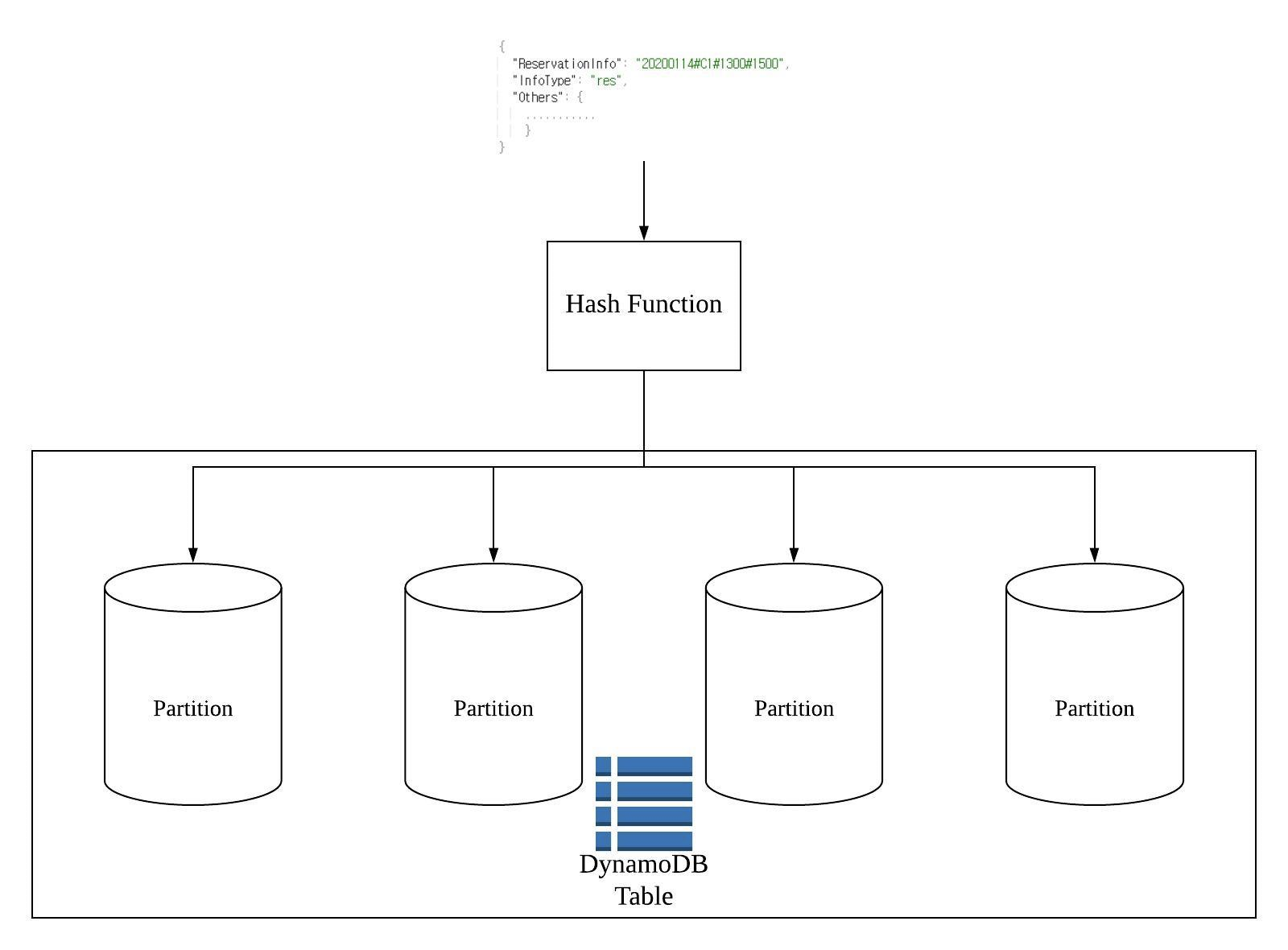

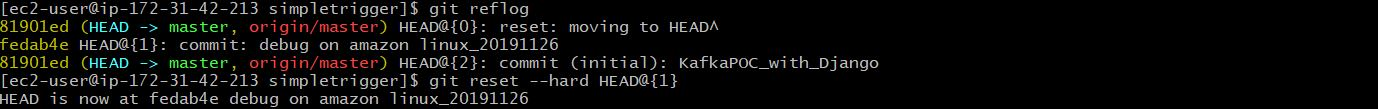

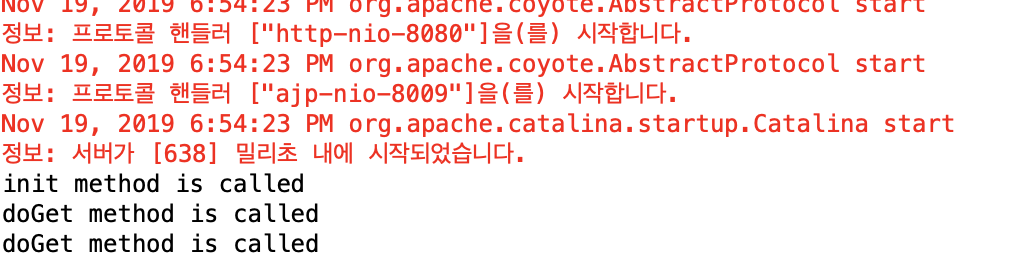

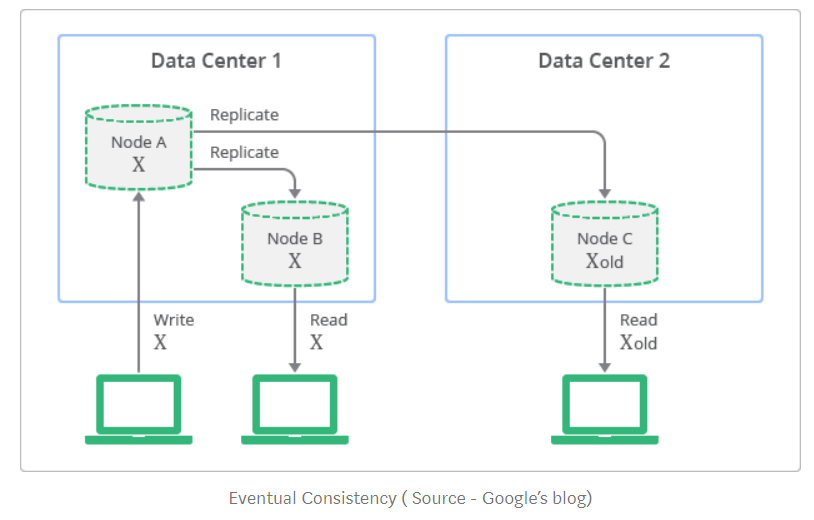

1. 올해 첫 직장에 입사하며 다룰 수 있었던 기술 1-1. AWS 기존의 알던 온프레미스 환경에서 벗어나 클라우드를 접하였다. 쓴만큼 지불한다는 개념이 존재하였기 때문에 각 클라우드 제품을 사용하는 것에 대한 최적화, 기반 기술, 한계점, 단위 비용에 대해 명확히 알고 있어야만 설계가 가능했다. 그러므로, 일반 개발자보다 훨씬 더 많은 학습을 통해 deep하게 공부를 할 필요성을 인지하였다. 중점적으로 사용한 서비스로는 Lambda, EC2, S3, API Gateway, EKS이다. 2020에는 EKS, MSK, Elastic Search 등 더욱 많은 서비스를 경험하여 내 것으로 만들 것이며 기반 기술에 대해 심도 있는 공부를 할 예정이다. 1-2. Kubernetes & Docker 입사 후 AW..